Za kulisami: Nasze laboratorium ML

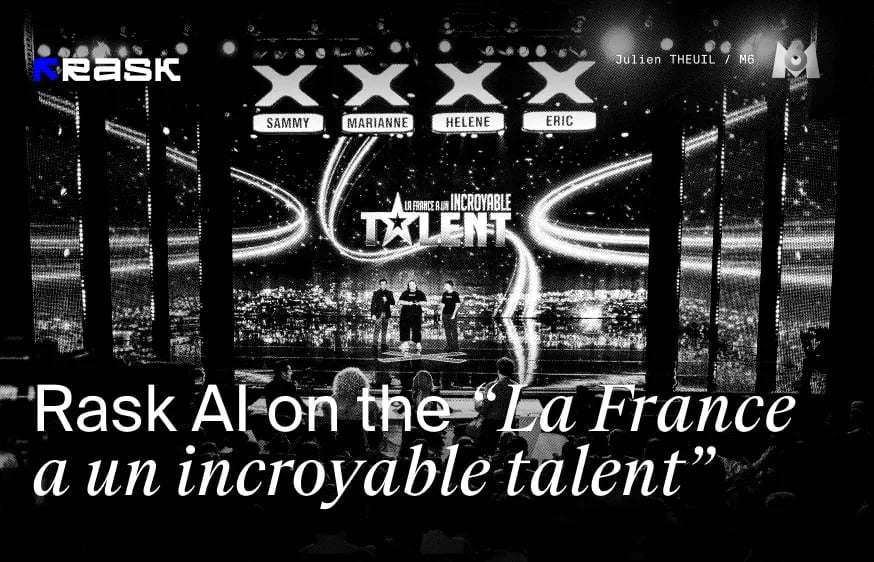

W naszym najnowszym artykule zagłębiamy się w ekscytujący świat technologii synchronizacji ruchu wargRask AI, korzystając ze wskazówek szefa firmy ds. uczenia maszynowego Dimy Vypirailenko. Zabieramy cię za kulisy Brask ML Lab, centrum doskonałości technologicznej, gdzie z pierwszej ręki widzimy, jak to innowacyjne narzędzie sztucznej inteligencji wywołuje fale w tworzeniu i dystrybucji treści. Nasz zespół składa się ze światowej klasy inżynierów ML i artystów syntetycznych VFX, którzy nie tylko dostosowują się do przyszłości; my ją tworzymy.

Dołącz do nas, aby dowiedzieć się, jak ta technologia zmienia branżę kreatywną, obniża koszty i pomaga twórcom dotrzeć do odbiorców na całym świecie.

Czym jest technologia Lip-Sync?

Jednym z głównych wyzwań w lokalizacji wideo jest nienaturalny ruch warg. Technologia synchronizacji ruchu warg została zaprojektowana, aby pomóc skutecznie synchronizować ruchy warg z wielojęzycznymi ścieżkami dźwiękowymi.

Jak dowiedzieliśmy się z naszego ostatniego artykułu, technika synchronizacji ruchu warg jest znacznie bardziej złożona w porównaniu do samego uzyskania odpowiedniego timingu - musisz uzyskać prawidłowe ruchy ust. Wszystkie wypowiadane słowa będą miały wpływ na twarz mówiącego, na przykład "O" oczywiście stworzy owalny kształt ust, więc nie będzie to "M", co znacznie komplikuje proces dubbingu.

Przedstawiamy nowy model Lip-sync o lepszej jakości!

Nasz zespół ML postanowił ulepszyć istniejący model synchronizacji ruchu warg. Jaki był powód tej decyzji i co nowego pojawiło się w tej wersji w porównaniu do wersji beta?

Podjęto znaczące wysiłki w celu ulepszenia modelu, w tym:

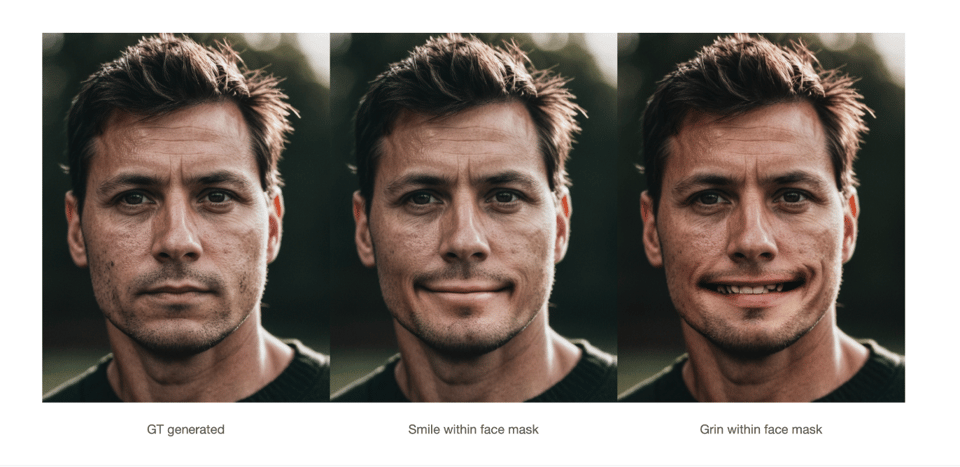

- Zwiększona dokładność: Udoskonaliliśmy algorytmy sztucznej inteligencji, aby lepiej analizować i dopasowywać szczegóły fonetyczne języka mówionego, co prowadzi do dokładniejszych ruchów warg, które są ściśle zsynchronizowane z dźwiękiem w wielu językach.

- Zwiększonanaturalność: Integrując bardziej zaawansowane dane z przechwytywania ruchu i udoskonalając nasze techniki uczenia maszynowego, znacznie poprawiliśmy naturalność ruchów warg, dzięki czemu mowa postaci wydaje się bardziej płynna i realistyczna.

- Większaszybkość i wydajność: Zoptymalizowaliśmy model pod kątem szybszego przetwarzania filmów bez utraty jakości, co pozwala skrócić czas realizacji projektów wymagających lokalizacji na dużą skalę.

- Uwzględnianie opinii użytkowników: Aktywnie zbieraliśmy opinie od użytkowników wersji beta i uwzględniliśmy ich spostrzeżenia w procesie rozwoju, aby rozwiązać określone problemy i zwiększyć ogólną satysfakcję użytkowników.

Jak dokładnie nasz model AI synchronizuje ruchy warg z przetłumaczonym dźwiękiem?

Dima: "Nasz model sztucznej inteligencji działa poprzez łączenie informacji z przetłumaczonego dźwięku z informacjami o twarzy osoby w kadrze, a następnie łączy je w ostateczny wynik. Ta integracja zapewnia, że ruchy warg są dokładnie zsynchronizowane z przetłumaczoną mową, zapewniając płynne wrażenia wizualne".

Jakie unikalne funkcje sprawiają, że Premium Lip-Sync jest idealnym rozwiązaniem dla wysokiej jakości treści?

Dima: "Premium Lip-sync został specjalnie zaprojektowany do obsługi wysokiej jakości treści dzięki swoim unikalnym funkcjom, takim jak możliwość obsługi wielu głośników i obsługa wysokiej rozdzielczości. Może przetwarzać filmy w rozdzielczości do 2K, zapewniając utrzymanie jakości wizualnej bez kompromisów. Dodatkowo, funkcja obsługi wielu głośników pozwala na dokładną synchronizację ruchu warg różnych mówców w ramach tego samego materiału wideo, dzięki czemu jest bardzo skuteczna w przypadku złożonych produkcji z udziałem wielu postaci lub mówców. Te cechy sprawiają, że Premium Lipsync jest najlepszym wyborem dla twórców dążących do profesjonalnej jakości treści".

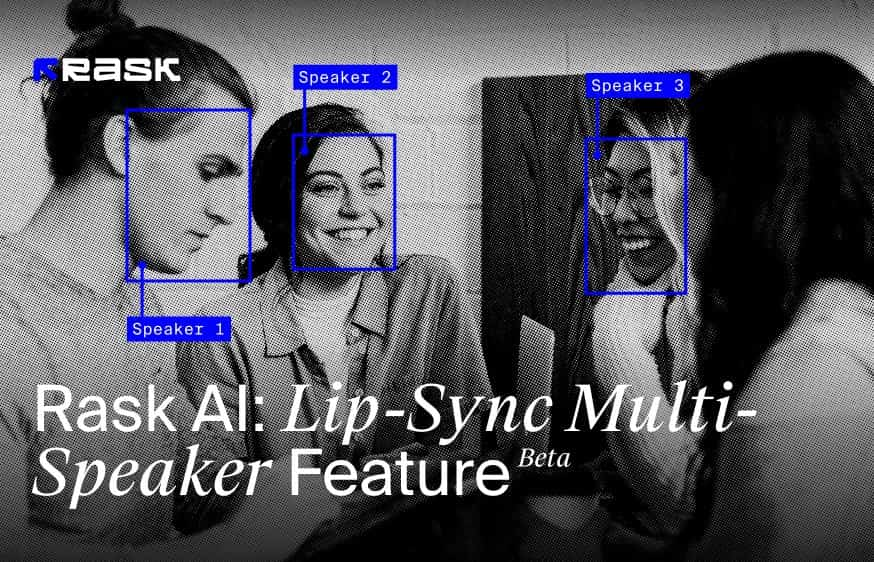

Czym jest funkcja Lip-Sync Multi-Speaker?

Funkcja Multi-Speaker Lip-Sync została zaprojektowana w celu dokładnej synchronizacji ruchów warg z wypowiadanym dźwiękiem w filmach, w których występuje wiele osób. Ta zaawansowana technologia identyfikuje i rozróżnia wiele twarzy w pojedynczej klatce, zapewniając, że ruchy warg każdej osoby są prawidłowo animowane zgodnie z wypowiadanymi przez nią słowami.

Jak działa synchronizacja ruchu warg z wieloma głośnikami?

- Rozpoznawanie twarzy w kadrze: Funkcja ta początkowo rozpoznaje wszystkie twarze obecne w kadrze wideo, niezależnie od ich liczby. Jest w stanie zidentyfikować każdą osobę, co ma kluczowe znaczenie dla dokładnej synchronizacji ust.

- Dopasowanie dźwięku: Podczas odtwarzania wideo technologia dopasowuje ścieżkę dźwiękową specjalnie do osoby, która mówi. Ten precyzyjny proces dopasowywania zapewnia, że głos i ruchy warg są zsynchronizowane.

- Synchronizacja ruchu warg: Po zidentyfikowaniu osoby mówiącej, funkcja synchronizacji ruchu warg przerysowuje ruchy warg tylko dla osoby mówiącej. Osoby niemówiące w kadrze nie będą miały zmienionych ruchów warg, zachowując swój naturalny stan w całym filmie. Ta synchronizacja dotyczy wyłącznie aktywnego mówcy, dzięki czemu jest skuteczna nawet w obecności głosów poza ekranem lub wielu twarzy w scenie.

- Obsługastatycznych obrazów ust: Co ciekawe, technologia ta jest również wystarczająco zaawansowana, aby przerysować ruchy warg na statycznych obrazach ust, jeśli pojawią się one w kadrze wideo, demonstrując jej wszechstronne możliwości.

Ta funkcja Multi-Speaker Lip-Sync zwiększa realizm i zaangażowanie widzów w scenach z wieloma mówcami lub złożonymi ustawieniami wideo, zapewniając, że tylko usta osób mówiących poruszają się zgodnie z dźwiękiem. To ukierunkowane podejście pomaga skupić się na aktywnym mówcy i zachowuje naturalną dynamikę interakcji grupowych w filmach.

Z jednego filmu w dowolnym języku można stworzyć setki spersonalizowanych filmów przedstawiających różne oferty w wielu językach. Ta wszechstronność rewolucjonizuje sposób, w jaki marketerzy mogą angażować różnorodnych i globalnych odbiorców, zwiększając wpływ i zasięg treści promocyjnych.

Jak zachować równowagę między jakością a szybkością przetwarzania w nowym Premium Lip-sync?

Dima: "Równoważenie wysokiej jakości z dużą szybkością przetwarzania w Premium Lipsync jest wyzwaniem, ale poczyniliśmy znaczne postępy w optymalizacji wnioskowania naszego modelu. Ta optymalizacja pozwala nam uzyskać najlepszą możliwą jakość przy przyzwoitej prędkości".

Czy są jakieś interesujące niedoskonałości lub niespodzianki, które napotkałeś podczas treningu modelu?

Dodatkowo, praca z okluzją wokół ust okazała się dość trudna. Elementy te wymagają starannej dbałości o szczegóły i zaawansowanego modelowania, aby uzyskać realistyczne i dokładne odwzorowanie w naszej technologii synchronizacji ust.

W jaki sposób zespół ML zapewnia prywatność i ochronę danych użytkowników podczas przetwarzania materiałów wideo?

Dima: Nasz zespół ML bardzo poważnie traktuje prywatność i ochronę danych użytkowników. W przypadku modelu Lipsync nie wykorzystujemy danych klientów do szkolenia, eliminując w ten sposób ryzyko kradzieży tożsamości. Opieramy się wyłącznie na danych open source, które są dostarczane z odpowiednimi licencjami do szkolenia naszego modelu. Ponadto model działa jako oddzielna instancja dla każdego użytkownika, zapewniając, że ostateczne wideo jest dostarczane tylko do konkretnego użytkownika i zapobiegając wszelkiemu splątaniu danych.

Naszym głównym celem jest wzmocnienie pozycji twórców, zapewnienie odpowiedzialnego wykorzystania sztucznej inteligencji w tworzeniu treści, z naciskiem na prawa i przejrzystość etyczną. Gwarantujemy, że Twoje filmy, zdjęcia, głosy i podobizny nigdy nie zostaną wykorzystane bez wyraźnej zgody, zapewniając ochronę Twoich danych osobowych i zasobów twórczych.

Jesteśmy dumnymi członkami The Coalition for Content Provenance and Authenticity (C2PA) i The Content Authenticity Initiative, co odzwierciedla nasze zaangażowanie w integralność i autentyczność treści w erze cyfrowej. Co więcej, nasza założycielka i CEO, Maria Chmir, została wyróżniona w katalogu Women in AI Ethics™, podkreślając nasze przywództwo w zakresie etycznych praktyk AI.

Jakie są przyszłe perspektywy rozwoju technologii synchronizacji ruchu warg? Czy istnieją konkretne obszary, które szczególnie Cię ekscytują?

Dima: Wierzymy, że nasza technologia synchronizacji ruchu warg może służyć jako podstawa do dalszego rozwoju w kierunku cyfrowych awatarów. Wyobrażamy sobie przyszłość, w której każdy może tworzyć i lokalizować treści bez ponoszenia kosztów produkcji wideo.

W perspektywie krótkoterminowej, w ciągu najbliższych dwóch miesięcy, jesteśmy zobowiązani do poprawy wydajności i jakości naszego modelu. Naszym celem jest zapewnienie płynnego działania na filmach 4K i poprawa funkcjonalności dzięki tłumaczeniu filmów na języki azjatyckie. Te postępy są kluczowe, ponieważ dążymy do poszerzenia dostępności i użyteczności naszej technologii, torując drogę dla innowacyjnych zastosowań w tworzeniu treści cyfrowych. Przełamywanie barier językowych nigdy nie było tak blisko! Wypróbuj naszą ulepszoną funkcję synchronizacji ruchu warg i prześlij nam swoją opinię na temat tej funkcji.

FAQ

Funkcja synchronizacji ruchu warg jest dostępna w planach Creator Pro, Archive Pro, Business i Enterprise.

Jedna minuta wygenerowanej synchronizacji ruchu warg równa się jednej minucie odejmowanej od całkowitego salda minut.

Minuty synchronizacji ruchu warg są odliczane tak samo, jak w przypadku dubbingu filmów.

Opłata za synchronizację ruchu warg jest naliczana oddzielnie od dubbingu. Na przykład, aby przetłumaczyć i zsynchronizować 1-minutowy film na 1 język, potrzebujesz 2 minut.

Przed wygenerowaniem synchronizacji ruchu warg będziesz mógł przetestować 1 bezpłatną minutę, aby ocenić jakość technologii.

Szybkość generowania synchronizacji ruchu warg zależy od liczby mówców w filmie, czasu trwania, jakości i rozmiaru filmu.

Na przykład, oto przybliżona szybkość generowania synchronizacji ruchu warg dla różnych filmów:

Filmy z jednym lektorem

- 4 minuty wideo 1080p ≈ 29 minut

- 10 minut 1080p ≈ 2 godziny 10 minut

- 10 minut wideo 4K ≈ 8 godzin

Filmy z 3 głośnikami:

- 10 minut 1080p ≈ 5 godzin 20 minut

- Prześlij swój film za pomocą linku z YouTube, Dysku Google lub bezpośrednio z urządzenia. Wybierz język docelowy i kliknij przycisk tłumaczenia.

- Dodaj lektora do swojego wideo w Rask AI za pomocą przycisku "Dub video".

- Aby sprawdzić, czy wideo jest zgodne z synchronizacją ruchu warg, kliknij przycisk "Sprawdź synchronizację ruchu warg".

- Jeśli jest kompatybilny, przejdź dalej, dotykając przycisku synchronizacji ust.

- Następnie wybierz liczbę twarzy w filmie - "1" lub "2+", a następnie dotknij "Rozpocznij synchronizację ust". Uwaga, chodzi o liczbę twarzy, a nie głośników.

Rask%20Lens%20A%20Recap%204.webp)